在AI领域,技术创新与突破一直是各大厂商和研究机构竞相追逐的焦点。近日,DeepSeek的梁文锋与月之暗面的杨植麟因各自发表的论文“撞车”而引发广泛关注。同时,DeepSeek迅速崛起让月之暗面陷入尴尬境地,甚至有消息称月之暗面已大幅降低广告投放。

2月18日,DeepSeek与月之暗面几乎同时发布了最新论文,主题都是挑战Transformer架构的核心注意力机制,旨在使其更高效处理更长上下文。DeepSeek的论文提出名为NSA的新架构,在基准测试中表现出色,准确率相同或更高,处理64k标记序列时速度提高至11.6倍,训练更高效且所需算力更少。

月之暗面的论文则提出了MoBA架构,使用将“词”变成块的方法,并设计了一套可以自由切换全注意力和稀疏注意力机制的方式,给现有全注意力模型更多适配空间。这两篇论文展示了两位创始人在技术领域的深厚功底,揭示了AI大模型技术发展的新方向。清华大学教授章明星指出,两篇论文都指向了可反向传递的learned sparse attention。

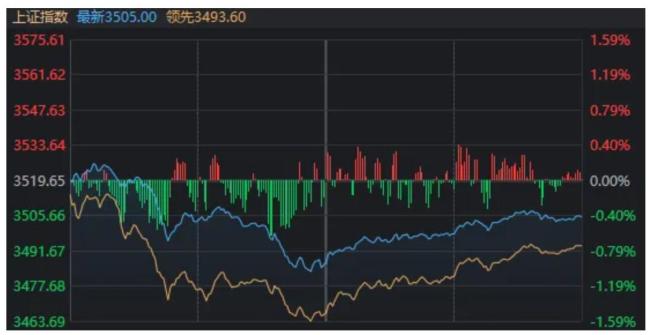

与此同时,DeepSeek凭借其强大的技术实力和精准的市场定位迅速崭露头角。据报道,DeepSeek在几十天内达到3500万DAU,这一成绩令业界震惊。相比之下,月之暗面虽然推出了Kimi等产品,但在用户增长方面显得力不从心。尽管投入大量资金进行广告投放,但效果不佳,一年多时间仅获得不足千万量级的日活数据。

DeepSeek的崛起给月之暗面带来了巨大压力。一方面,DeepSeek的技术实力和市场表现削弱了月之暗面的技术优势;另一方面,DeepSeek的迅速扩张也挤压了月之暗面的市场份额。在此背景下,月之暗面不得不重新审视自己的市场定位和技术路线。团队计划重新训练基础模型,同时关注应用层机会,如参考OpenAI的DeepResearch产品方向。尽管月之暗面拥有多模态能力、资本储备和品牌余温等优势,但在竞争激烈的AI市场,留给它的时间窗口正在缩小。

从行业影响来看,DeepSeek的爆发重塑了中国大模型赛道。资本逻辑从过去的“烧钱换估值”转向关注技术性价比与商业化闭环;生态链重构,百度、腾讯等大厂纷纷接入DeepSeek的开源模型,闭源玩家生存空间被挤压;技术平民化趋势显现,算法创新降低了对进口硬件的依赖,国产芯片能效比提升。在这样的环境下,月之暗面面临巨大挑战,如何在开源生态、成本控制或垂直场景中找到新支点成为破局关键。